编者按:本文来自手势交互方案提供商 锋时互动 的投稿。

Pokémon GO 让 AR 和手游、街头甚至社交相结合,仅仅是这几个关键词就足够吸引人,再加上 Pokémon 这一世纪大 IP,好像不火反而没道理。但是在手机上用长按→滑动的触屏操作模拟“抛出”精灵球,将宝可梦收入其中……会不会有些略显拘谨和中二?虽然国服还未开放,但是中国玩家对 Pokémon GO 的思考和想象并不少,Pokémon GO 确实带给我们很多惊喜,但是玩家最期待看到的不是技术最初级的样子,而是将之与最适合的技术表现形式相结合,从情节设计和操作方式来看,VR/MR+手感操控或许能带给玩家更爽的体验。

开脑洞容易,但实现呢?

我们和 易瞳科技 一起尝试了 VR 和 MR 版 Pokémon GO,宝可梦从手机屏幕中解禁,玩家可以抓住想要选择的精灵球,在眼前调整角度瞄准后冲着宝可梦抛出。如果你遇到的是一只刚烈而又狡猾的宝可梦,为了避免被带节奏,还可以打圈儿扔出最强旋转精灵球、投喂食物,大概没有哪只宝可梦可以从玩家手中逃脱了。

关于开发教程

相信各位老司机们对 VR 的了解已经非常透彻,微动和易瞳携手做的这段 demo 除了想要帮大家解锁抓宝可梦的新姿势,还想把 MR+手感操控的技术表现形式普及给大家,以下为开发教程,除此之外 SDK 也可以在微动 Vidoo 官网免费下载,期待开发者在吃下这记良心安利后会有更多大作产生。

手感操控:

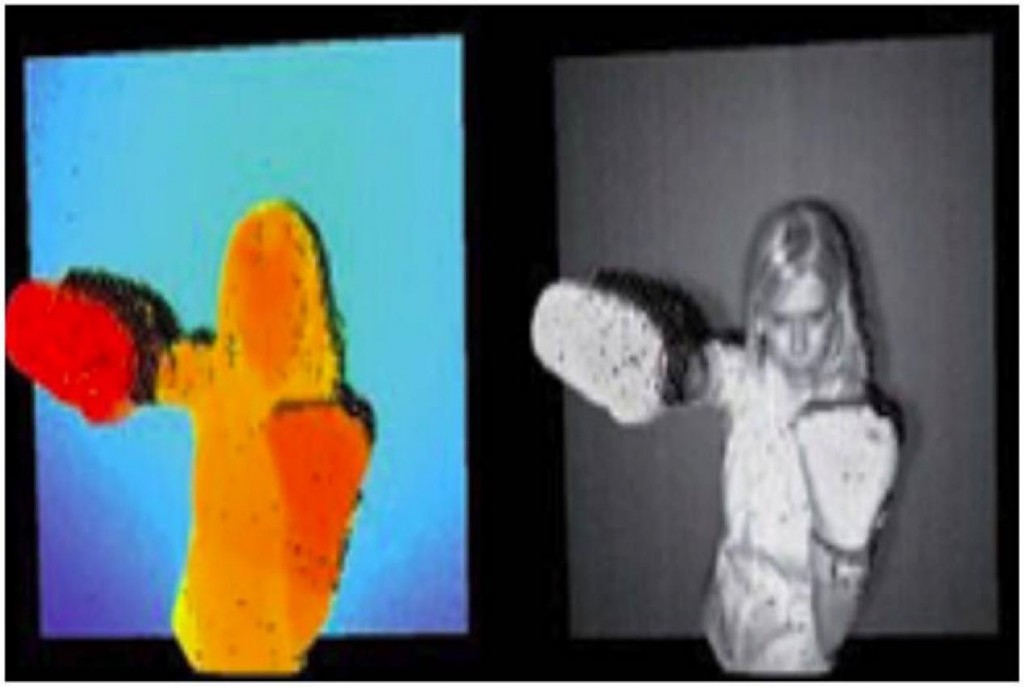

首先,通过微动的双目深度传感器得到深度图像。在深度图像中,我们通过修改每个像素 RGB 的值用以标定该像素与传感器之间的距离。当我们观察深度图像时,会发现其效果与我们熟悉的红外热成像图像类似,只不过我们把温度替换成了距离。下图中,左侧为深度图像,右侧为原始图像。通过观察可以看出,距离越近的区域,颜色越红;距离越远的区域,颜色越蓝。

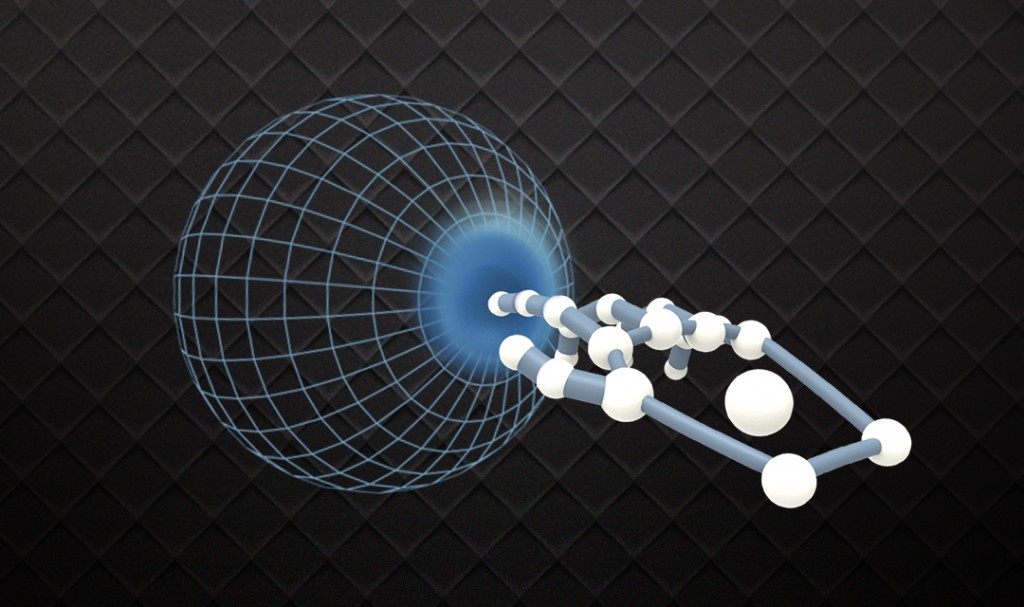

其次,我们将深度图像中符合人体手部特征的部分分割出来,进行手部姿态、动作的识别。这里需要指出的是手势识别算法是基于深度图像而不是普通图像的。这样可以方便我们获得手部每个点的深度信息。从而还原出整手的骨骼结构。如果我们想要与虚拟物体进行触碰式的交互,骨骼结构是不可缺失的技术前提。

最后,我们通过算法将传感器坐标系(包含手部骨骼空间信息)、虚拟世界坐标系(包含所有虚拟物体的空间信息)、现实坐标系(包含环境信息和手部信息)这三个坐标系对齐。这样,我们可以将检测到的手部骨骼与真实的双手对齐;将虚拟物体与现实环境对齐。当真实的手部触碰到虚拟的物体时,将会产生类似鼠标点击的事件,来驱动程序的执行,具体到 Pokémon GO 里面,就是投喂小精灵,扔出精灵球等操作。

革新人类视觉感知的能力,不仅涉及到对现实进行数字叠加,还需要用到增删改等其他视觉修饰手段,从上世纪 90 年代开始,MR(介导现实)的研究逐步在多伦多大学的 HI 实验室中展开,一批顶尖学科人才从 HI 实验室脱颖而出。

MR 显示

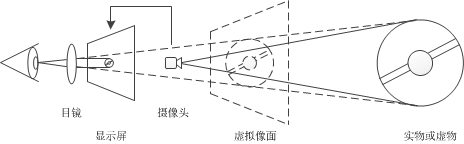

接下来,我们要做的就是在空间当中显示 Pokémon GO 中的游戏元素,并且让皮卡丘和精灵球显示在合理的空间范围之内。我们采用视频透视技术,通过双目摄像头实时采集你看到的“现实”世界并将之数字化,然后通过计算机算法实时渲染画面。这样做完既可以完全叠加虚拟图像,也可以看到的经过计算机渲染后新的“现实画面”。满足了我们对于虚拟物体和现实环境同时存在的需求。

在解决了交互和显示核心技术之后,在 Unity3D 里面加入相应的 SDK,调整下流程逻辑。MR 版 Pokémon GO 便诞生啦!

介导现实技术 MR

值得注意的是本文提到的“MR”并非“混合现实”。MR 是介于 VR 与 AR 之间的技术,名为介导现实技术,由“智能硬件之父”多伦多大学教授 SteveMann 提出的介导现实,全称 Mediated Reality(简称 MR)。VR 是纯虚拟数字画面,包括 AR 在内的 Mixed Reality 是虚拟数字画面+裸眼现实,MR 是数字化现实+虚拟数字画面。

MR 也并非近几年才出现,上世纪七八十年代,为了增强自身视觉效果,让眼睛在任何情境下都能够“看到”周围环境,Steve Mann 设计出可穿戴智能硬件”Digital Eye Glass” 作为视觉辅助设备,这被看作是对 MR 的初步探索。

至此,已完成了手感操控的基础部分,后续将进一步在 Unity3D 中完善事件的逻辑,完成 Pokémon GO 中将精灵球、食物抛向小精灵的功能。

“手感操控”非“手势识别”

手感操控不等于手势识别,手感操控包括手势识别。手感操控要满足以下三个基本点:

微动 Vidoo Primary 手感控制器

微动 Vidoo 是可以应用于移动端的手感操控设备,可以完成手部影像坐标系与虚拟世界坐标系的重合,构建 1:1 的虚拟手感操控空间;交互过程中使用原始的手部图像,使用者就像是在用自己真实的双手与 VR/AR/MR 世界中的虚拟物体进行交互;不再使用头部瞄准作为选择的工具,让显示交互与指令交互分离。微动的下一代产品,将双目模组作为传感基站,可同时进行手感操控、空间定位、光学手柄的检测,致力于打造完整的虚拟现实交互解决方案。除此之外它还将致力于为车载电子、全息投影、智能家居等前沿领域提供手感操控的软/硬件解决方案。

微动 Vidoo 和易瞳在硬件和软件层面已达成深入合作。易瞳科技 CTO 艾韬师承 Steve Mann,曾带领团队在计算机视觉,计算机摄影等领域取得多项技术突破,最终将 MR 概念落地为产品。2016 年 8 月,易瞳科技推出全球首款 MR 智能眼镜“易瞳 VMG-PROV”(下图)。

免责声明:以上内容为网上采集的文章、图片,出于对行业传递更多信息之目的,若本文章涉嫌侵犯到您的权益,请及时向info@idform.cn进行反馈,核实无误后进行删除